Introduction

Nous avons pu voir dans les retours d’expériences qui précèdent cet article que le passage d’une évaluation “traditionnelle” au format papier à une évaluation en ligne pouvait être issu d’une volonté de transformation pédagogique de la part d’une équipe d’enseignants ou bien une adaptation contrainte face à un contexte particulier comme celui vécu lors de la période de la Covid-19.

Les enseignants du supérieur sont désormais nombreux à avoir expérimenté au moins une fois l’évaluation en ligne. Ces évaluations en ligne ont pu être vécues comme des occasions propices à l’expérimentation pédagogique par les enseignants volontaires qui souhaitaient tester cette modalité. Cependant, d’autres enseignants, ainsi que certains étudiants, ont pu vivre une mauvaise expérience lors de ce passage à l’évaluation en ligne notamment lorsque celle-ci était imposée et non anticipée.

Ainsi, lors de nos discussions avec les enseignants et lors de nos accompagnements à l’hybridation des enseignements nous nous sommes rendu compte que l’évaluation en ligne cristallisait certaines représentations déjà abordées précédemment (difficultés de prise en main des outils, temps d’acculturation et de mise en place, bugs possibles, etc.). Selon certains enseignants, la triche serait un des principaux freins les empêchant d’expérimenter les évaluations en ligne. En effet, de nombreux enseignants estiment que la triche est davantage pratiquée par les étudiants lors des examens en ligne. Nous précisons que les termes « triche » et « fraude » seront volontairement employés indistinctement dans cet article.

Afin de dépasser le stade des représentations, nous tâcherons donc d’apporter un éclairage sur cette problématique en posant la question suivante : la triche est-elle facilitée par l’évaluation en ligne ?

Nous définirons dans un premier temps ce qu’est la fraude en proposant une classification de celle-ci. Des données chiffrées permettront d’illustrer la manifestation de cette fraude et les raisons qui poussent les étudiants à tricher seront abordées. Puis dans un second temps, nous détaillerons les différents enjeux liés à l’évaluation en ligne pour les établissements du supérieur. Des bonnes pratiques et des contremesures pour faire face à la fraude lors d’une évaluation en ligne seront ainsi proposées afin d’aider les enseignants à assurer le bon déroulement de ce type d’examens.

1. La triche et l’évaluation en ligne

1.1. Qu’est-ce que la triche ?

Avant de nous attarder sur la fraude en ligne, il nous faut déterminer ce qu’est la triche dans le contexte de l’enseignement et en définir le périmètre. Guibert et Michaut (2009, p. 45) rappellent ainsi que les « théories de la désignation (Lemert, 1967 ; Beckert 1985) ont bien mis en évidence le poids du jugement social sur la perception de la déviance. C’est pourquoi demander simplement aux étudiants s’ils ont triché (ou pas) n’a que très peu de sens, dans la mesure où les réponses qui seraient obtenues recouvriraient des définitions hétérogènes ». Ainsi nous n’avons pas tous la même définition de la triche. Cependant la littérature scientifique nord-américaine s’est depuis longtemps penchée sur la question. Plutôt que de fournir une définition, dont l’exercice parait complexe, Guibert et Michaut préfèrent donc retenir une liste des pratiques de triches les plus fréquentes établies sur la base des travaux de Lambert, Hogan et Barton (2003) à savoir :

- « copier, plagier » : copier sur la feuille du voisin, récupérer le brouillon du voisin, recopier un texte ou une partie d’un texte et le présenter comme un travail personnel, reproduire le travail d’un autre étudiant sans y faire référence ;

- « falsifier » : les résultats d’une expérience, d’une enquête, son identité ;

- « leurrer le correcteur » : inscrire plusieurs réponses en espérant que le correcteur accordera des points pour l’une d’entre elles ; indiquer dans une bibliographie des ouvrages ou des articles non lus ; demander un délai supplémentaire pour rendre un travail en donnant une excuse factice ; utiliser une synthèse, lire un résumé plutôt que l’ouvrage original ;

- « utiliser des supports non autorisés » : antisèche, dictionnaire, calculatrice programmable, etc. ;

- « s’entraider illicitement » : demander à une personne de faire à sa place un travail ; demander la réponse à un autre étudiant ; se répartir le travail à plusieurs ».

Les points relevés précédemment nous permettent donc de mieux délimiter ce qui relève de la triche. Les auteurs rappellent néanmoins que ces types de triche sont présents depuis des années (Marchand, 2008, dans Guibert & Michaut, 2009). Marchand prend l’exemple du baccalauréat qui, dès sa création, a posé des problèmes. Les candidats profitaient de cette organisation à grande échelle où il était difficile de contrôler l’identité pour faire appel à des « passeurs » qui usurpaient leur identité afin de passer l’examen à leur place.

En effet, si l’on reprend les cinq types de fraude évoqués précédemment, nous pouvons constater que les TICE constituent une nouvelle opportunité de triche :

- « Copier, plagier » devient plus aisé, car l’apprenant peut accéder à Internet et disposer d’une large banque de données et profiter du copier-coller.

- La « falsification » peut intervenir lorsque nous ne pouvons pas prouver que la personne en ligne est réellement celle que nous souhaitons évaluer. Plus récemment c’est le cas des intelligences artificielles (IA) telles que ChatGPT qui préoccupent les établissements scolaires, ces dernières étant capables de répondre à des questions relativement complexes, de résoudre des problèmes et ou encore de générer des écrits proches de ceux que pourraient rédiger des humains. Cet outil de triche est difficilement détectable et vérifiable. Il est donc compliqué pour les enseignants de distinguer une réponse originale de celle qui aurait été fournie par ce type d’IA.

- « Leurrer le correcteur » peut se traduire, par exemple, par de fausses déclarations de l’apprenant sur des difficultés de connexion, des problèmes techniques liés au matériel utilisé pour passer l’examen, etc.

- « Utiliser des supports non autorisés » reste l’une des pratiques les plus courantes car les moyens de tricher se sont développés avec l’apparition des baladeurs audios puis des téléphones.

- « S’entraider illicitement » car les étudiants peuvent profiter de la distance pour échanger des documents et des réponses sans que l’enseignant puisse en avoir connaissance. Les TICE permettent également l’émergence de groupes d’échanges en ligne (forums, discussions instantanées via des applications, etc.) accessibles pendant un examen.

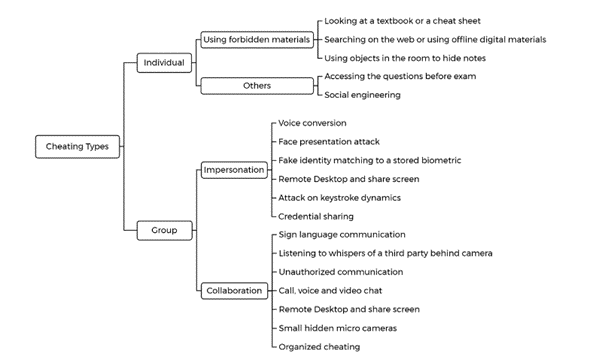

Nous proposons également ci-dessous un organigramme (figure 2) publié dans une enquête intitulée « A systemic review of research on cheating in online exams from 2010 to 2021 » (Noobehbahani et al., 2022). Celui-ci permet de mettre en avant les formes de triche liées à une personne (usage de matériel interdit par exemple) ou au groupe (pour lesquelles les auteurs distinguent « l’usurpation d’identité » et la « collaboration »).

1.2. Quelques données sur la triche scolaire et universitaire

Guibert et C. Michaut (2009) ont donc mené une enquête sur la triche à l’université en envoyant un questionnaire à l’ensemble des étudiants d’une université pluridisciplinaire française (environ 32 000 étudiants). Ils ont obtenu les réponses de 1 815 étudiants en les interrogeant sur sept thèmes différents :

- « pratiques, représentations et justification des tricherie scolaire et universitaire ;

- connaissances des sanctions ;

- conditions de surveillance des examens ;

- pratiques extra-universitaires de fraude […] ;

- scolarité antérieure, formation suivie et manières d’étudier ;

- conditions de vie et pratiques culturelles ;

- caractéristiques socio-démographiques. » (Guibert et Michaut, 2009, p. 44)

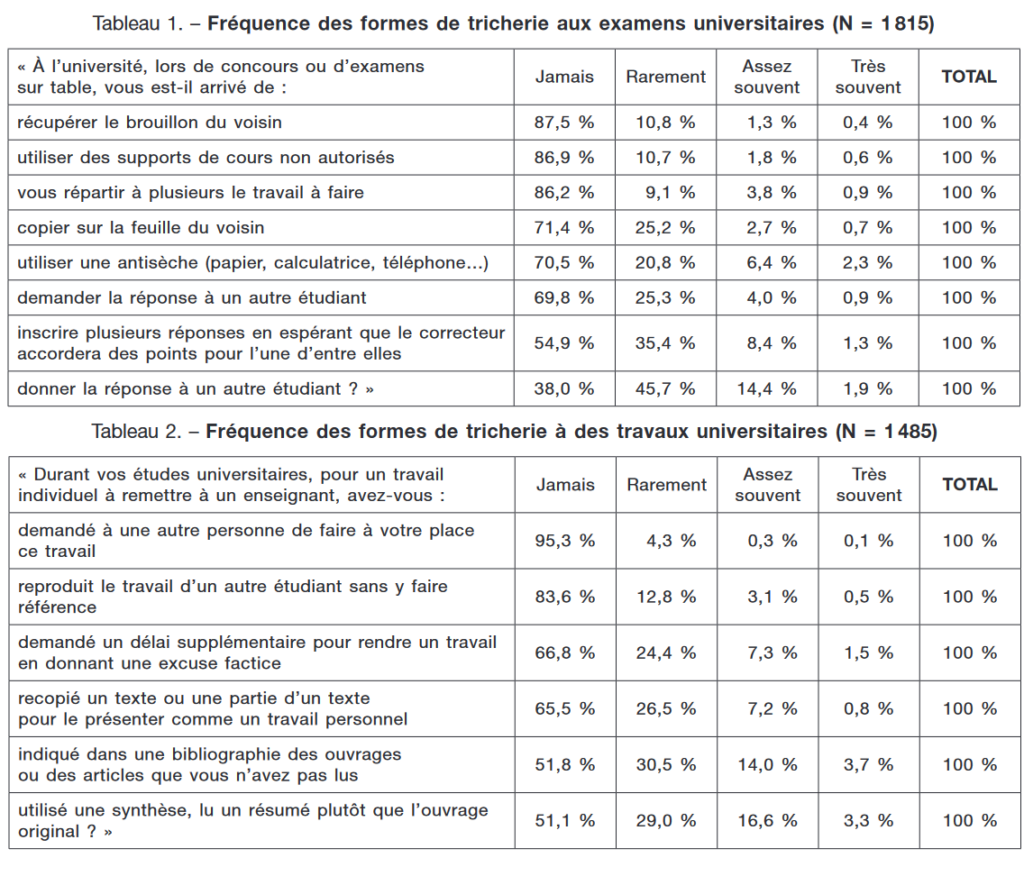

Parmi les éléments intéressants que les chercheurs relèvent dans leurs résultats, il y a ce pourcentage de 70,5 % d’étudiants qui avouent avoir déjà triché lors de leur scolarité. Les auteurs ont synthétisé certains résultats afin d’obtenir deux tableaux permettant de relever la fréquence des différentes formes de tricherie aux examens universitaires et lors des travaux universitaires (ibid, p. 46-47). Les deux tableaux sont proposés ci-dessous.

Parmi les données de ces tableaux, certaines sont mises en avant par les auteurs . Aussi, ils remarquent que plus de 85 % des étudiants n’ont jamais récupéré le brouillon de leur voisin ou utilisé des supports de cours non-autorisés. « Copier sur la feuille du voisin » ou « utiliser une antisèche » restent les pratiques les plus fréquentes bien qu’elles soient tout de même occasionnelles. « Demander [ou] donner la réponse à un autre étudiant » est également un type de fraude assez récurrent. Plus étonnant, on remarque que leurrer l’enseignant en inscrivant plusieurs réponses est une pratique très répandue, les auteurs interprétant cela comme « un contournement des pratiques universitaires ». Enfin, pour les travaux universitaires plus de 15 % des étudiants avouent avoir déjà indiqué dans une bibliographie des ouvrages ou des articles qu’ils n’ont pas lus et ou ont déjà utilisé une synthèse plutôt qu’un ouvrage original. Si l’on pense que la triche est surtout utilisée par les étudiants pour obtenir une note plus élevée, les auteurs émettent également l’hypothèse selon laquelle les méthodes de triche pourraient être interprétées comme des « moyens d’apprentissage visant à se simplifier la vie » .

Nous l’avons expliqué au début de cette partie en citant les propos de Guibert et Michaut, les étudiants n’ont pas tous la même perception de ce qu’est la triche. En effet, certaines déviances pourraient être interprétées comme de la triche par les enseignants tandis que des étudiants pourraient justifier ces comportements en les rapprochant des stratégies d’apprentissages. Ainsi la triche « Donner la réponse à un autre étudiant » pourrait être perçue comme une simple entraide par l’étudiant communiquant les réponses à ses camarades. Les formes suivantes « indiqu[er] dans une bibliographie des ouvrages ou des articles que vous n’avez pas lus » et « utilis[er] une synthèse, [lire] un résumé plutôt que l’ouvrage original » pourraient être des déviances volontaires de la part d’étudiants mettant en place des stratégies pour faire face à un contexte d’évaluation dans lequel ils ne se sentent pas à l’aise (manque de temps, surcharge de travail, etc.). Ce sont ces différentes raisons de tricher que nous tenterons d’éclaircir dans la partie qui suit.

1.3. Les raisons de la triche ?

Dans cette enquête intitulée « Les facteurs individuels et contextuels de la fraude aux examens universitaires » parue en 2009, Guibert et Michaut s’intéressent également à des critères sociologiques liés aux apprenants questionnés afin d’analyser ces résultats. De manière synthétique, il ressort de leurs analyses que les expériences antérieures de l’apprenant, son genre ainsi que le contexte dans lequel il est évalué sont des paramètres qui peuvent influer sur sa propension à tricher. Ainsi, les auteurs remarquent que les étudiants avouant avoir déjà triché à l’université sont ceux qui avaient déjà des habitudes de triche au lycée. Ils arrivent à la conclusion que « rares sont ceux qui deviennent tricheurs en entrant à l’université et que l’intensité de la fraude aux examens dépend fortement de l’expérience déjà acquise par les étudiants dans ce domaine » (ibid. p. 47). Par ailleurs, les auteurs constatent que 35 % des filles disent n’avoir jamais triché pendant leurs études universitaires tandis qu’ils sont presque 25 % chez les garçons. Cette donnée serait, selon les auteurs, à mettre en corrélation avec les résultats comparés entre les différentes formations, où l’on peut remarquer que les Lettres, le Droit et la Psychologie sont les formations avec les fréquences de triche les plus faibles (filières où les filles sont plus nombreuses que les garçons). En effet, selon les réponses obtenues via le questionnaire, les étudiants de Sciences et technologies sont plus nombreux à déclarer tricher aux examens. Enfin, les auteurs posent l’hypothèse selon laquelle la triche serait davantage présente si le contexte d’examen était favorable. Or l’analyse des « conditions de surveillance des examens » fait apparaître que cette hypothèse est partiellement validable car les étudiants de Sciences et technologies (qui ont moins l’opportunité de tricher selon les critères choisis) s’avèrent être ceux qui tricheront quand même le plus par rapport aux étudiants de Lettres Langues et Sciences Humaines ou de Droit, Économie et gestion qui avouent avoir plus d’opportunités de tricher. Au-delà du contexte et du type d’exercice demandé lors des examens, les auteurs choisissent de retenir une interprétation plus sociologique de ces résultats en se référant aux travaux de Erlich (1998) et expliquent que « les étudiants de sciences et techniques, tout particulièrement ceux inscrits en IUT, trichent davantage que les autres étudiants, dans la mesure où la sociabilité des étudiants dans ces formations est plus prononcée ». (Guibert et Michaut, 2009, p. 49)

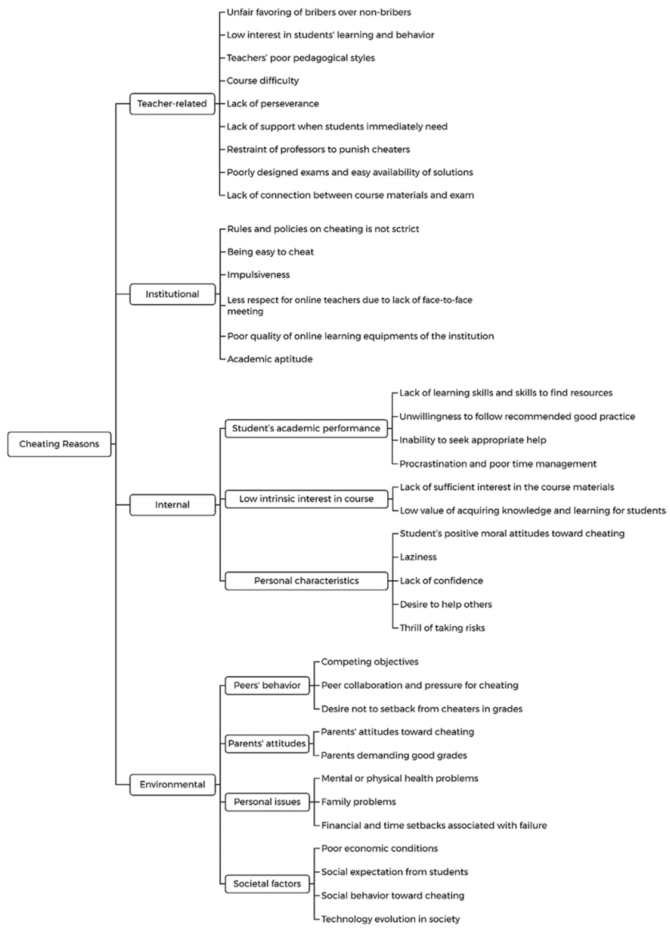

La synthèse des recherches menées sur la triche lors des évaluations en ligne réalisée par Noorbehbahani, Mohammadi et Aminazadeh (2021) confirme les raisons potentielles de la triche chez l’apprenant (voir figure 3 ci-dessous). Certaines étaient déjà évoquées par Guibert et Michaut (2009) comme les caractéristiques « internes » de l’apprenant (son niveau académique, son manque de motivation lié au cours, ou ses traits de caractères) ou son « environnement » (réaction des parents, influence des pairs, problèmes personnels ou sociaux ). Il semble cependant difficile pour l’université d’agir sur ces critères sur lesquels elle n’a pas d’emprise directe.

Néanmoins, les trois auteurs pointent des raisons à la triche sur lesquelles l’université et les enseignants pourraient avoir un impact. Pour eux, ces facteurs seraient liés à « l’institution » (règles et politiques qui ne sont pas assez strictes, la triche trop facile ou encore le mauvaise qualité des équipements pour les cours en ligne proposés par l’institution ) ou encore liés directement à « l’enseignant » (le manque d’intérêt pour l’apprentissage et l’environnement des apprenants, les méthodes pédagogiques choisies, des évaluations peu qualitatives et trop simplistes, ou le manque de lien entre le contenu vu en cours et l’évaluation).

1.4. Existe-t-il un lien entre les pratiques de triche et les TICE ?

C’est la question que beaucoup se posent. Avec le développement des TICE, nous serions tentés de penser que les étudiants trichent davantage car cela semble plus aisé et les moyens utilisés sont plus difficilement détectables. Afin de vérifier si cette hypothèse est fondée, nous nous appuierons sur des enquêtes menées à l’étranger faisant la comparaison entre des examens « papiers » et des examens en ligne. Des retours d’expériences à l’Université d’Angers vous sont également proposés dans ce dossier.

1.4.1. L’exemple de l’université algérienne 8 Mai 45-Guelma

Une professeure de Français a mené une enquête sur l’évaluation en ligne au sein de l’université 8 Mai 45-Guelma (Algérie) auprès de de 100 enseignants et 130 étudiants du département de Langue et Littérature française en fournissant des questionnaires différents pour les deux populations. Après l’analyse des résultats l’auteure arrive à la conclusion suivante : « les enseignants et les étudiants résistent et n’adhèrent pas à la pratique de l’évaluation [mais] l’adoption de l’évaluation à distance aiderait à prévenir et à réduire le phénomène de la tricherie et de la malhonnêteté universitaire » (Razika, 2022, p. 31).

Pour mettre en relief les résultats de l’enquête, il nous faut relever certains chiffres. Nous apprenons ainsi que les étudiants de ce département sont coutumiers de la triche (89 % avouent tricher lors d’examens officiels). Cependant, « seuls » 60 % de ces étudiants ont eu recours à la triche lors de l’évaluation à distance tout en confiant qu’ils n’arrivaient pas forcément à trouver les réponses souhaitées. En effet, à la question « La technologie numérique aide-t-elle à tricher ? » la répartition est égale, 50 % estimant que c’est le cas car ils arrivent à trouver toutes les informations nécessaires et 50 % pensant le contraire avec des réponses telles que « il y a tellement d’informations qu’on se perd et finalement on s’égare par rapport à la réponse demandée » (ibid, p. 32). On peut en conclure que la moitié de la promotion ne perçoit par l’intérêt de tricher lors d’évaluations en ligne.

L’autre aspect intéressant de cette enquête est l’opinion des enseignants sur l’évaluation en ligne. En effet, 68 % d’entre eux « observent que le phénomène de la triche (plagiat, copier-coller) a nettement diminué » avec ce type d’évaluation. Pour 40 % d’entre eux les « résultats obtenus lors de l’évaluation en ligne se rapprocheraient des résultats obtenus ordinairement » tandis que 60 % considèrent que « les résultats étaient meilleurs lors de l’évaluation en présentiel ». Les enseignants sont 55 % à être satisfaits de l’évaluation en ligne et 70 % d’entre eux estiment que « l’évaluation n’a aucun impact négatif sur la formation des étudiants ». Dernier chiffre intéressant, 90 % d’entre eux affirment que la formulation des sujets et des questions est différente lors de l’examen en ligne, certains confiant ainsi : « on doit concevoir les sujets d’examens d’une façon à ce que les étudiants ne trouvent pas les réponses sur Internet, ils seront appelés à faire un travail authentique, personnel et autonome » (ibid., p. 35). Nous verrons dans notre troisième partie les bonnes pratiques à avoir pour mettre en place l’évaluation en ligne.

1.4.2. L’exemple de l’université norvégienne de sciences et de technologie

Trois professeurs de l’université norvégienne de sciences et de technologie (NTNU) ont également décidé de mener une enquête intitulée « Cheating in e-exams and paper exams : the perceptions of engineering students and teachers in Norway » (Chirumamilla et al., 2020). Cette enquête souhaitait rendre compte de la perception qu’avaient les étudiants (212 répondants) et les enseignants (197 répondants) des évaluations « papiers » et en ligne grâce à un questionnaire complété par quelques interviews semi-dirigées de certains étudiants. Les questions de recherche des enseignants étaient les suivantes :

« RQ1: What are student and teacher perceptions about the frequency of the six listed types of cheating during on-campus written university examinations? This RQ makes no comparison of paper exams and e-exams, and its purpose is to get some context about the magnitude of the problem.

RQ2-3: Is there a significant difference between paper, BYOD, and university PC when it comes to ease of cheating (in any of the six ways listed above), as perceived by students (RQ2) and teachers (RQ3)?

RQ4-5: Is there a significant difference between paper exams and e-exams in the effectiveness of countermeasures against cheating, as perceived by students (RQ4) and teachers (RQ5)? Here, we only made one comparison (i.e. paper exams to e-exams) rather than three different comparisons, to avoid a too long survey.

RQ6: Are there differences between student and teacher perceptions of ease of cheating, and the effectiveness of countermeasures? » (ibid., p. 4).

Les auteurs ont choisi de comparer les facilités de triche entre différentes formes d’évaluation :

- examens « papiers » versus examens en ligne où les étudiants apportent leurs propres ordinateurs (BYOD : Bring Your Own Device) ;

- examens où les étudiants apportent leurs propres ordinateurs versus lorsque les étudiants utilisent les ordinateurs mis à disposition par l’université ;

- et enfin examens « papiers » versus examens où les étudiants utilisent les ordinateurs mis à disposition par l’université.

Voici un bref résumé des résultats intéressants issus de ces confrontations.

Les étudiants et les enseignants considèrent tous que l’examen le plus sensible à la triche est celui du type « BYOD ». En effet, les étudiants pourraient avoir installé des logiciels spéciaux ou avoir stocké des documents sur leurs ordinateurs en amont de l’évaluation pour y accéder par la suite. Par ailleurs, les étudiants pointent que le verrouillage des navigateurs internet pendant un examen en ligne ne leur semble pas être une solution totalement sécurisée.

Les étudiants pensent qu’il est également plus facile de copier lors des examens en ligne par rapport aux examens « papiers » car les écrans surélevés facilitent la lecture des réponses chez les camarades. Néanmoins ils jugent plus aisée l’utilisation d’aides interdites telles que les antisèches lors d’examens « papiers » car elles seraient faciles à dissimuler entre d’autres copies. Sur la question de la surveillance des examens, les étudiants et les enseignants s’accordent en pensant que cette contremesure serait plus efficace dans le cadre d’examens papiers par rapport aux examens en ligne. Ils se justifient en expliquant que les surveillants sont souvent des personnes âgées ou peu familières des méthodes de triche en ligne. Ces dernières auraient donc plus de difficultés à les identifier.

Les deux populations estiment que d’autres contremesures seraient plus simples à implanter lors des évaluations en ligne (le mélange des questions, le tirage aléatoire des questions ou des sujets, l’utilisation de la navigation séquentielle dans un test avec l’impossibilité de revenir en arrière, l’enregistrement vidéo lors de l’examen ou encore la vérification des données biométriques des étudiants). Pour certaines de ces contremesures, une partie des étudiants émet néanmoins des réserves. En effet, ils sont sceptiques concernant le respect de l’équité et de la justice si la mesure du « tirage aléatoire » est utilisée. Par ailleurs, ils sont également inquiets par l’utilisation de leurs données personnelles lors de ce type d’examen. Nous y reviendrons plus loin dans cet article. Ce type de contremesure a été testé lors du dispositif d’évaluation en ligne proposé en Lettres, Langues et Sciences Humaines à l’Université d’Angers (voir dans ce dossier « Analyse d’une évaluation en ligne en LLSH »).

Pour conclure, parmi les trois types d’évaluations évoqués précédemment, les étudiants et les enseignants s’accordent pour dire que l’évaluation en ligne de type BYOD serait celle où il serait plus simple de tricher. Cependant, ces deux populations estiment que les contremesures face à la triche seraient moins contraignantes à mettre en place pour les examens en ligne que pour les examens « papiers » bien que certaines peuvent également être appliquées aussi dans le cadre de ces examens.

Cela dit, à la question « Est-ce que les étudiants trichent davantage lors des examens en ligne ? », nous ne pouvons pas répondre directement par l’affirmative. L’enquête de l’université algérienne a montré que les étudiants ne trichaient pas davantage lors des évaluations en ligne. L’enquête de l’université norvégienne a montré que la communauté pédagogique estimait que l’évaluation en ligne était plus sensible à la triche malgré des contremesures plus simples à mettre en place. Nous pensons donc qu’avec le développement de contremesures efficaces en fonction du type d’examen en ligne, il n’y a pas de raisons pour que les évaluations en ligne deviennent moins sécurisées que des évaluations « papiers ».

Nous pouvons donc conclure que l’évaluation en ligne ne suscite pas nécessairement plus de triche que lorsqu’elle est réalisée au format « classique » (feuille et stylo). Les facteurs de triche sont plus larges que le simple contexte de passation de l’examen. Il faut considérer les expériences antérieures de l’apprenant, son niveau académique ou encore ses caractéristiques personnelles. Néanmoins, il convient de noter que les modalités d’évaluation ont chacune des caractéristiques pouvant favoriser la triche, que ce soit les évaluations « en ligne » (manque ou absence de surveillance ou de règles strictes, utilisation de son propre matériel) tandis que d’autres sont inhérentes à n’importe quel type d’évaluation (mauvais alignement pédagogique, évaluations trop simplistes ou manquant de sens). Il faudra donc prendre conscience des limites de l’évaluation en ligne et s’efforcer d’agir sur certains leviers afin de continuer à profiter des avantages liés à ce type d’évaluation.

2. L’évaluation en ligne, une opportunité pour l’université ?

Comme expliqué plus haut dans cet article (et lors des retours d’expériences présentés précédemment dans ce dossier) la formation à distance s’est développée depuis le début des années 2002 avec l’émergence des TICE. De nombreuses expérimentations pédagogiques autour de l’évaluation en ligne ont donc pu avoir lieu. Néanmoins, la crise sanitaire mondiale de la Covid-19 a forcé les enseignants à adopter ce type de technologies pour continuer d’évaluer leurs étudiants. Il semble ainsi intéressant de questionner les enjeux liés à ce nouveau mode d’évaluation et de tirer profit des expérimentations menées jusqu’ici afin de faire preuve de résilience.

2.1. Des enjeux multiples pour les universités

Depuis 2015, des e-examens à valeurs certificatives sont par exemple proposés grâce à une initiative de la Commission européenne avec la plateforme OLS (Online linguistic support). Des étudiants ou des personnels souhaitant participer aux programmes « Erasmus + » ou au « Corps européen de solidarité » peuvent désormais obtenir des certifications en langue grâce à des évaluations entièrement réalisées à distance. C’est le cas par exemple du TOEFL (Test of English as a foreign language) qui propose des modules pédagogiques en ligne et une évaluation délivrant une certification.

Les établissements scolaires ont la responsabilité de délivrer des diplômes et doivent se soucier de la qualité de leurs méthodes d’évaluation en ligne. La littérature scientifique attire donc l’attention des établissements sur « les notions de fiabilité (retrouver certainement le même résultat dans d’autres conditions de passation) et de validité (c’est ce qui doit être évalué qui est évalué) » (Huver et Spinger, 2011 : 25, cités dans C. Lindgren, 2013, p. 116).

Benoît Sillard, président de la société TestWe spécialisée dans les examens en ligne, liste ainsi plusieurs enjeux auxquels sont maintenant confrontés les établissements lorsqu’ils souhaitent mettre en place des examens en ligne (B. Sillard dans N. Chagny, 2022, p. 65-66). Ces établissements doivent « garantir [leur] réputation et montrer [leur] capacité à évoluer ». En effet, les diplômes et les certifications qu’ils délivrent doivent avoir une valeur reconnue sur le marché du travail. Or s’ils ne peuvent garantir que leurs examens (en ligne ou en présentiel) se déroulent dans des conditions sécurisées et vérifiées, leur crédibilité pourrait être mise en cause. « Rassurer sur les compétences et les connaissances des diplômés » est un autre élément important notamment pour des étudiants ayant passé des examens à distance de manière contrainte en 2020 et qui craignent que leur formation soit insuffisante et dépréciée sur le marché du travail. L’entrepreneur pointe cinq freins auxquels peuvent être confrontés les établissements souhaitant organiser des examens en ligne :

- « le risque de triche » : même si ce risque n’est pas directement lié à l’évaluation en ligne, il semble que les opportunités de tricher sont facilitées lors d’un test passé à distance.

- « le manque de motivation des étudiants » : certains étudiants ayant passé leurs examens à distance de manière contrainte en 2020 expriment des craintes liées à la viabilité et la sureté de ce type d’évaluations, ces craintes pouvant les pousser à frauder.

- « la fracture numérique » : pour que les étudiants puissent être évalués en ligne, les conditions d’examens doivent être favorables (outil informatique à disposition, qualité de la connexion à internet, etc.). Une enquête menée par Bentayeb Razika à l’Université de Guelma en Algérie, intitulée « Crise de la covid-19 et son impact sur l’évaluation en ligne : avantages et limites » (2022, p. 33), fait apparaître que « 60 % des étudiants interrogés affirment que le mode de l’évaluation en ligne a un effet négatif sur eux à cause des conditions de travail peu propices » et que « 65 % d’entre eux opteraient pour le mode d’évaluation en présentiel s’ils étaient amenés à exercer la profession d’enseignant car ils pensent qu’elle est moins stressante et qu’elle pose des soucis d’ordre matériel (outils à disposition, connexion, etc.). »

- « la confidentialité des données » : l’entrepreneur explique que ce n’est pas parce que les étudiants s’exposent de plus en plus sur les réseaux sociaux qu’ils ne sont pas attentifs au traitement de leurs données. Il rappelle que des règles strictes ont été édictées par la Commission Nationale de l’Informatique et des Libertés (CNIL). Nous les rappellerons plus loin dans cet article.

- « le coût » : ici l’entrepreneur évoque l’investissement qui peut être conséquent pour s’équiper d’une solution d’examen en ligne télésurveillée.

Les freins peuvent donc sembler importants pour organiser des examens en ligne tout en s’assurant de leur validité et de leur fiabilité. Mais nous allons voir qu’il existe des solutions pour pallier la triche, qui est l’un des principaux freins, et que des bonnes pratiques peuvent être adoptées pour assurer la qualité de ce type d’examens.

2.2. Les réponses pour faire face à la triche

Nous venons de l’évoquer précédemment dans cet article, la triche reste l’un des principaux freins lorsque l’on souhaite mettre en place une évaluation en ligne. Même si des recherches ont pu démontrer qu’il n’y avait pas de corrélation directe entre la disponibilité des TICE et une fraude plus aisée, la communauté éducative est en quête de réponses pour faire face à cette problématique. En ce sens B. Sillard (ibid., p. 67-69) évoque deux types de réponses possibles : la réponse « technologique » et la réponse « pédagogique ».

2.2.1. Les réponses technologiques et institutionnelles

La réponse « technologique » est souvent la première à laquelle on pense et consiste à améliorer les méthodes de surveillance. Pour cela on peut demander à l’étudiant d’allumer sa webcam, qu’il soit seul dans la pièce si l’examen est à distance, etc. Il est nécessaire de faire signer à l’étudiant une demande de droit à l’image pour ce type de surveillance. D’autres solutions comme la « prise de son » peuvent être envisagées pour vérifier si l’étudiant n’est pas en train de se faire communiquer les réponses . Néanmoins, l’auteur pointe des limites à ces méthodes.

Tout d’abord, il faut veiller à respecter le cadre légal en vigueur en France concernant la protection des données privées. En effet, la vérification de l’identité de l’étudiant est très encadrée par le Parlement européen et le Conseil de l’union européenne : « En particulier, les finalités spécifiques du traitement des données à caractère personnel devraient être explicites et légitimes, et déterminées au moment de la collecte des données à caractère personnel. » (Schulz & Hennis-Plasschaert, 2016). L’auteur nous rappelle également que la CNIL a dû se positionner en France concernant les prestations de télésurveillance. Elle impose ainsi aux prestataires de « produire une documentation détaillée sur la manière dont seront gérées les données, […] les modalités du contrôle pendant l’examen. Le consentement de l’étudiant doit être libre et dans ce cas, un autre choix proposé à l’étudiant, sans qu’il puisse subir des conséquences de son refus » (B. Sillard dans N. Chagny, 2022, p. 68). Selon la CNIL, la surveillance vidéo en temps réel pendant un examen, la prise de photographies ou de flux vidéo ou sons de manière ponctuelle ou aléatoire ne sont pas des dispositifs disproportionnés. Les dispositifs de surveillance disproportionnés sont ceux permettant de prendre le contrôle à distance de l’ordinateur personnel de l’étudiant et ceux reposant sur des traitements biométriques (exemple : reconnaissance faciale via une webcam). (CNIL, 20 mai 2020).

Un des rapports de l’Inspection générale de l’administration de l’Éducation nationale et de la Recherche (Mazodier et al., 2012) fait état de la fraude aux examens dans le supérieur. Parmi les sujets qui préoccupent le plus l’Inspection nous retrouvons donc le plagiat. Le rapport indique que les universités commencent à se doter progressivement de logiciels anti-plagiat (ex : Compilatio à l’Université d’Angers).

Mais au-delà des réponses technologiques, le problème est également institutionnel. Le rapport précédemment cité rappelle les différents types de sanctions existantes : avertissement, blâme, exclusions temporaires et définitives. Des sanctions pénales peuvent également être appliquées pour la triche aux examens ou aux concours publics . Il est écrit dans ce rapport que « Si la nécessité de lutter à titre préventif contre la fraude n’est pas contestée, il n’y a pas réel consensus sur les procédures à adopter en cas de fraude ou de plagiat constaté » (p. 21). Sans mentionner réellement un laxisme de la part de certains établissements, le rapport propose néanmoins d’être plus sévère et préconise de : « Permettre aux établissements d’adopter une politique de tolérance zéro [qui] impose un dispositif permettant la réprimande rapide sans sanction excessive ». (p. 54).

Les réponses technologiques sont donc souvent limitées (droits à respecter) et les réponses institutionnelles sont parfois inefficaces pour dissuader les étudiants de tricher car elles ne sont pas suffisamment nombreuses et impactantes.

2.2.2. Les réponses pédagogiques

Parmi les pistes possibles, reste celle de la réponse « pédagogique ». Les propositions faites dans la conclusion du rapport intitulée « Et si on évaluait autrement ? » (p. 59-60) sont en effet intéressantes et misent davantage sur une évolution des pratiques plutôt que sur la sanction ou sur les stratégies technologiques. Le rapport pointe plusieurs éléments pouvant permettre d’augmenter le risque de fraude comme le fait de répéter son cours et ses évaluations d’une année à l’autre, de centrer son évaluation sur la restitution de connaissances ou encore le manque de coordination des équipes pédagogiques concernant le calendrier des évaluations.

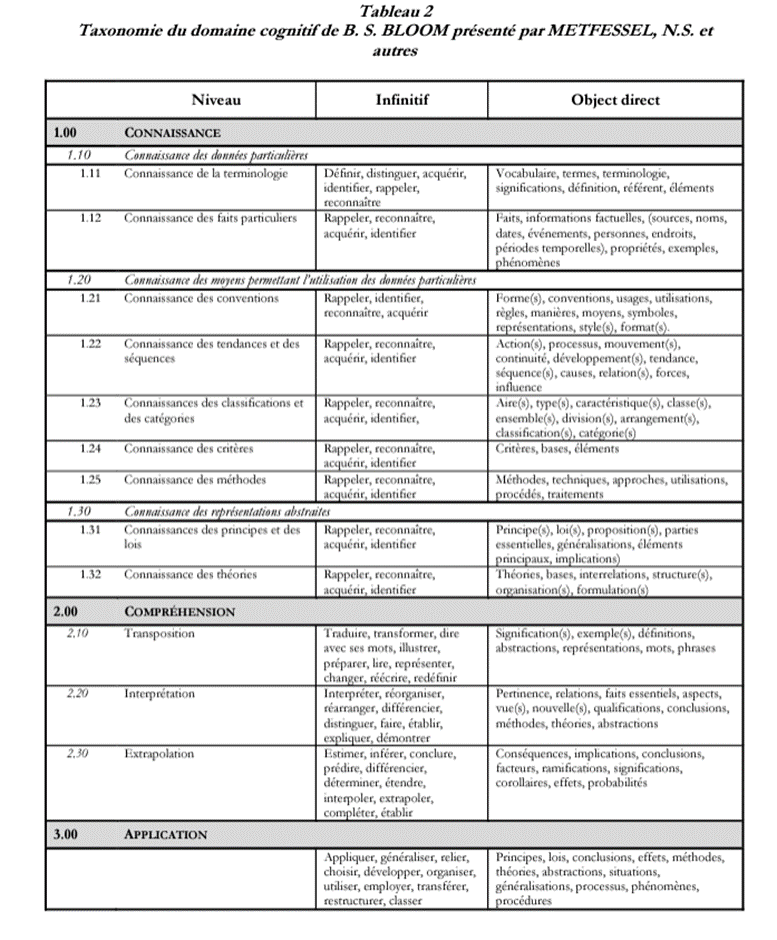

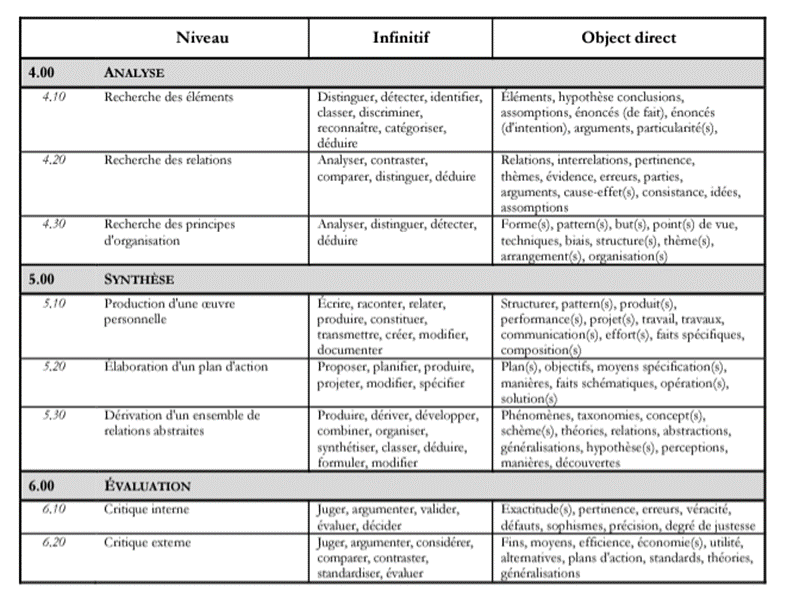

Comme nous avons pu le voir lors des deux retours d’expériences qui précèdent cet article, il y a également un véritable enjeu à viser des « niveaux taxonomiques » élevés lors des évaluations, qu’elles soient en ligne ou non. La taxonomie de Bloom est une classification d’objectifs d’apprentissage en différents niveaux de complexité (Bloom, 1969). Cette taxonomie est souvent représentée sous la forme d’une pyramide avec, à sa base, le niveau taxonomique le moins élevé et à son sommet celui le plus élevé. À cette taxonomie s’ajoute parfois la liste de Metfessel, Michael et Krisner (1969) qui vient compléter la taxonomie initiale en y ajoutant des listes de capacités et des verbes à utiliser dans la formulation et l’évaluation des objectifs à chaque niveau de la taxonomie (voir Annexes). B. Sillard propose ainsi trois grands types d’évaluation en ligne pour lesquelles nous pourront identifier des niveaux taxonomiques variés (dans N. Chagny, 2022, p. 63) :

- L’examen de contrôle de connaissances : l’étudiant répond la plupart du temps à des questions (QCM ou ouverte) dans un temps imparti et sans aide. Niveaux taxonomiques visés : Acquisition, Compréhension.

- L’évaluation où l’on veut vérifier si l’étudiant est capable de mobiliser ses connaissances et d’appliquer certains concepts/procédures. L’étudiant peut utiliser ses notes le jour de l’examen (« cheat sheet »). Niveaux taxonomiques visés : Compréhension, Application, Analyse.

- L’évaluation mobilisant l’esprit critique de l’étudiant, lui demandant d’évaluer quelque chose ou de s’auto-évaluer, ou encore de faire preuve de créativité. Il peut utiliser tous les supports qu’il souhaite (« open-book »). Niveaux taxonomiques visés : Analyse, Synthèse, Évaluation.

Selon les rapporteurs, l’émergence des TICE depuis plusieurs années a révélé une fragilité voire une inadaptation des modes d’évaluation. La dernière recommandation du rapport serait donc de repenser les évaluations. Les rapporteurs proposent d’aller vers une évaluation permettant de certifier de niveaux de compétences plutôt que de vérifier « la simple restitution de connaissances que l’on a engrangées ». Ils citent en exemple les pays scandinaves où les étudiants peuvent apporter toutes les sources nécessaires afin de nourrir une réflexion personnelle et de répondre à des problématiques. En France nous avons le cas des épreuves de Droit ou le code civil et pénal sont autorisés comme « instruments professionnels », ou encore en Pharmacie avec l’épreuve du commentaire d’ordonnance où les étudiants peuvent disposer de leurs propres documents ou le cours. Les « exercices inductifs » menés en sciences humaines sont également appréciés car les écrits porteraient sur les observations faites sur le terrain. Les rapporteurs concluent de la sorte : « il est clair que les modifications des formes d’évaluation devront donner une place bien supérieure aux travaux collectifs et aux restitutions orales de ces travaux ». Ils recommandent enfin de se rapporter aux fiches du Répertoire National des Certifications Professionnelles (RNCP) pour déterminer les compétences professionnelles que les enseignants souhaiteraient faire acquérir à leurs étudiants. Elles les aideront ainsi à concevoir les examens en conséquence.

Cette réponse pédagogique implique donc un véritable changement dans les pratiques des équipes pédagogiques qui ont besoin d’être conseillées et accompagnées dans cette transition.

2.3. Et si on changeait ensemble notre vision de l’évaluation ?

Comme nous avons pu le voir précédemment, les avantages de l’évaluation en ligne sont nombreux et pourront être perçus comme une optimisation par rapport à la forme plus traditionnelle de l’examen en présentiel avec un papier et un stylo (correction automatique, abolition de l’espace et du temps, feedbacks instantanés, gain de temps pour l’enseignant, évaluation de grands groupes, etc.). Cependant, certaines limites ont été pointées et ce type d’évaluations pourrait être qualifié de forme « dégradée » (évaluation en ligne imposée, triche, problèmes matériels, perte de sens et démotivation des étudiants, etc.). Nous terminerons donc cet article en proposant plusieurs pistes pour organiser une évaluation en ligne de qualité.

Dans son article « Modes d’évaluation numérique des apprentissages » (2022, p. 70-72), B. Sillard identifie trois acteurs à considérer pour veiller au bon déroulement de l’examen en ligne : l’équipe pédagogique, l’institution et les étudiants. Il fournit alors des préconisations pour chacun de ces acteurs.

Premièrement, un point essentiel serait de « Motiver l’équipe pédagogique ». Pour cela, il faudrait former les enseignants à l’évaluation en ligne. C’est d’ailleurs en ce sens que le Lab’UA, le Service d’appui à l’innovation pédagogique de l’Université d’Angers , propose plusieurs formations au catalogue de l’université d’Angers (« Utiliser Wooclap en grand groupes », « Réveillez la force du QCM », « L’activité test / le dépôt de devoirs dans Moodle », etc.). L’auteur préconise également aux enseignants d’échanger entre eux et de faire des tests, estimant qu’il faudrait expérimenter trois à quatre évaluations en ligne pour être pleinement convaincu. Une autre piste pour engager les équipes serait de leur faire prendre conscience des avantages précédemment cités concernant l’examen en ligne. Ce dernier permettrait en effet aux enseignants de simplifier leurs corrections grâce à la correction automatique et de suivre plus efficacement les progrès de leurs étudiants grâce aux indicateurs fournis par la plateforme numérique. Le temps gagné avec la correction automatique de certaines questions permettrait aux enseignants de s’attarder sur les questions plus complexes, nécessitant une correction manuelle, et d’optimiser le suivi pédagogique de leurs étudiants en fournissant des corrections ou des conseils plus qualitatifs. C’est d’ailleurs le constat que font les enseignants interrogés lors de nos différents retours d’expérience.

Deuxièmement, B. Sillard conseille à l’institution « d’anticiper l’aspect organisationnel ». L’auteur rappelle ainsi l’intérêt de proposer à l’étudiant plusieurs « examens blancs ». L’enseignant veillerait ainsi à l’alignement pédagogique de son enseignement en permettant à l’étudiant de se familiariser avec la méthode d’évaluation choisie (éviter les bugs, l’appréhension, etc.). Pour B. Sillard, il est également essentiel de communiquer en amont sur le mode d’évaluation et de rester disponible et bienveillant le jour de l’évaluation si des problèmes techniques venaient à se manifester. Il faudrait également indiquer clairement aux étudiants les comportements répréhensibles en définissant un cadre réglementaire. Cela peut passer par une charte, comme celle mise en place à l’Université d’Angers. Il est important que l’étudiant s’engage à respecter ce cadre (signature papier ou électronique) et qu’il consente au traitement de ses données en lui précisant dans quels cas elles seront utilisées.

Enfin troisièmement, l’auteur conseille de « rassurer les étudiants » en fournissant par exemple le matériel technique le jour de l’évaluation ou en laissant aux étudiants la possibilité du BYOD (« bring your own device »). Enfin, pour conclure, il faudrait proposer des évaluations avec des degrés taxonomiques plus élevés (QROL permettant l’analyse plutôt que le QCM se limitant à la vérification des connaissances) et des modes de restitutions plus originaux faisant appel à la créativité (oral, formats audio et vidéo) permettant également de limiter la triche.

Conclusion

À l’heure où nous écrivons ces lignes, un grand sujet occupe l’enseignement, et plus largement le débat public : l’utilisation des intelligences artificielles telles que ChatGPT. Ces technologies remettent en question nos modalités d’évaluation, qu’il s’agisse d’examens en ligne ou non. Après la crise de la covid-19, qui a contraint les équipes pédagogiques à organiser des évaluations en ligne pour assurer la continuité pédagogique, c’est maintenant un nouveau défi auquel elles vont devoir faire face.

En attendant l’émergence de possibles réponses technologiques, comme la détection de textes produits par des intelligences artificielles, c’est davantage la piste des réponses pédagogiques et institutionnelles qu’il nous semble pertinent d’explorer. Pour cela, des solutions permettant d’assurer la cohabitation d’examens en présentiel et en distanciel nous semblent être une option intéressante. Les examens en ligne, grâce à leur praticité, seront certainement amenés à perdurer. L’usage raisonné et pertinent de l’évaluation en ligne pourra dès lors constituer une forme d’« optimisation » de l’évaluation « traditionnelle » si toutes les précautions sont prises. Comme nous avons pu l’expliquer dans cet article, il sera cependant nécessaire à l’avenir que les établissements puissent garantir la « validité » et la « fiabilité » de ce type d’examens. Nous avons donc proposé une synthèse des bonnes pratiques à avoir pour la tenue d’un examen en ligne. L’aspect le plus intéressant selon nous, valable également pour les examens en présentiel, consisterait à transformer les méthodes d’évaluation pour les faire évoluer vers des niveaux taxonomiques plus élevés afin de limiter les possibilités de fraude .

Nul doute que les universités qui auront su anticiper ces changements en réfléchissant à des contremesures pertinentes et proportionnées seront les mieux parées pour faire face au développement de ces nouvelles technologies et aux formes de triche qu’elles peuvent favoriser. Nous pensons qu’elles doivent percevoir ce défi comme une véritable opportunité de transformer profondément les pratiques d’enseignement afin de préparer efficacement les étudiants à leur future vie professionnelle.

Annexes

Annexe 1 : Taxonomie du domaine cognitif de B.S. BLOOM présenté par METFESSEL, N.S et autres. La présentation sous forme de tableau est reprise du livre de Viviane et Gilbert de Landsheere, Définir les objectifs de l’éducation. (pp.88-91, Presses Universitaires de France, Paris. 1975.)

Bibliographie

Bloom, B. S., & Krathwohl, D. R. (1956). Taxonomy of educational objectives; the classification of educational goals by a committee of college and university examiners. Handbook I : Cognitive Domain. New York, NY ; Longmans, Green.

Commission Nationale de l’Informatique et des Libertés. (2020, 20 mai). Surveillance des examens en ligne : Les rappels et conseils de la CNIL. Site de la CNIL. https://www.cnil.fr/fr/surveillance-des-examens-en-ligne-les-rappels-et-conseils-de-la-cnil

Schulz, M. & Hennis-Plasschaert, J.-A. (2016, 27 avril). Directive (UE) 2016/680 du Parlement européen et du Conseil (législation 119/89). Journal officiel de l’Union européenne. Consulté 24 avril 2023, à l’adresse https://eur-lex.europa.eu/legal-content/FR/TXT/HTML/?uri=CELEX%3A32016L0680

Lambert E., Hogan N. & Barton S. (2003). « Collegiate academic dishonesty revisited: what have they done, how often have they done it, who does it, and why did they do it? ». Electronic journal of sociology, n° 3. Consulté le 26 avril 2023. URL : https://sociology.lightningpath.org/ejs-archives/vol7.4/lambert_etal.html

Lindgren, C. (2013). Dépasser la dichotomie entre évaluation formative et sommative : l’évaluation en ligne au département de français de l’université de Dalécarlie. Synergies Pays Scandinaves, (8), 113–126. Consulté le 26 avril 2023 à l’adresse suivante : http://urn.kb.se/resolve?urn=urn:nbn:se:du-15020

Metfessel, N.S., Michael, G. & Kirsner, G. (1969). Instrumentation of Bloom’s and Krathwohl’s taxonomies. Psychology in the school. 6. (3). 13-23.

Noorbehbahani, F., Mohammadi, A., & Aminazadeh, M. (2022). A systematic review of research on cheating in online exams from 2010 to 2021. Education and Information Technologies, 27(6), 8413‑8460. https://doi.org/10.1007/s10639-022-10927-7

Guibert P. & Michaut C. (2009) « Les facteurs individuels et contextuels de la fraude aux examens universitaires », Revue française de pédagogie, dossier 169, p 43-52. https://doi.org/10.4000/rfp.1404

Mazodier, M. Blemont, P., Foucault, M. & Kesler, S. (2012, 1er avril). La fraude aux examens dans l’enseignement supérieur (Rapport public n°27). Inspection générale de l’administration de l’éducation nationale et de la recherche. Consulté le 17 mai 2023 à l’adresse suivante : https://www.vie-publique.fr/rapport/32507-la-fraude-aux-examens-dans-lenseignement-superieur

Razika B. (2022). Crise de la covid-19 et son impact sur l’évaluation en ligne : avantages et limites. El-Bahith en des Sciences Humaine et Sciences Sociales, Vol 13 numéro 1, p. 25-38 https://www.asjp.cerist.dz/en/downArticle/503/13/1/179936

Sillard, B. (2022). Modes d’évaluation numérique des apprentissages. Enjeux numériques, S’approprier et apprendre le numérique, numéro 17. https://www.annales.org/enjeux-numeriques/2022/resumes/mars/14-en-resum-FR-AN-mars-2022.html#14FR